В аналитике данных одной из ключевых задач является нахождение экстремума функции, то есть точек, где функция достигает своих наибольших или наименьших значений. Это позволяет нам определить оптимальные решения в различных ситуациях и сделать более точные прогнозы.

Существует множество методов для поиска экстремума функции, каждый из которых имеет свои особенности и применим там, где другие способы неэффективны.

Один из наиболее распространенных методов - метод градиентного спуска, который основан на поиске определенных точек, где градиент функции (вектор ее частных производных) равен или близок к нулю. Этот метод позволяет находить минимумы для многомерных функций и широко применяется в машинном обучении.

Другой метод - метод перебора, который заключается в последовательном вычислении значения функции на некотором интервале с заданным шагом. Этот метод достаточно простой и позволяет найти экстремумы для одномерных функций. Однако он может быть очень времязатратным, особенно если интервал большой или шаг маленький.

В данной статье мы рассмотрим различные методы поиска экстремума функции и оптимальные стратегии их применения. Мы изучим достоинства и недостатки каждого метода, а также рассмотрим практические примеры, чтобы лучше понять их эффективность в аналитике данных.

Методы поиска экстремума функции

Одним из наиболее распространенных методов является метод градиентного спуска. В этом методе используется градиент функции, который указывает направление наиболее быстрого убывания функции. Начиная с некоторой начальной точки, метод градиентного спуска последовательно обновляет текущую точку, двигаясь в направлении, обратном градиенту функции. Таким образом, метод градиентного спуска позволяет приближаться к точке экстремума функции.

Еще одним методом поиска экстремума функции является метод Ньютона. Этот метод использует информацию о поведении функции в окрестности текущей точки для приближенного нахождения точки экстремума. Он основан на разложении функции в ряд Тейлора и замене функции более простой функцией сходной локальной структурой. Метод Ньютона обычно сходится быстрее, чем метод градиентного спуска, но может быть менее устойчивым к начальному приближению и некоторым другим факторам.

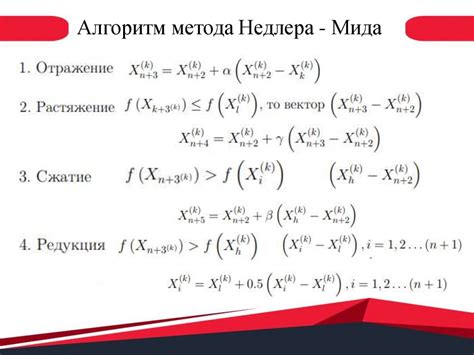

Другие методы поиска экстремума функции включают методы сопряженных градиентов, метод Нелдера-Мида, квазиньютоновские методы и многие другие. Каждый из этих методов имеет свои преимущества и недостатки, и выбор метода зависит от конкретной задачи и свойств функции.

В итоге, методы поиска экстремума функции играют важную роль в аналитике данных, позволяя находить оптимальные значения и решать различные задачи оптимизации. Выбор правильного метода поиска экстремума функции может существенно влиять на результат работы и эффективность решения задачи.

Стратегии нахождения оптимальных значений в аналитике данных

Существует несколько стратегий нахождения оптимальных значений в аналитике данных. Одна из основных стратегий - градиентный спуск, который основывается на итеративном обновлении значений переменных функции с целью минимизации или максимизации функции. Градиентный спуск часто используется в задачах машинного обучения и оптимизации моделей.

Еще одной стратегией является метод Ньютона, который используется для нахождения экстремумов функций. Он основан на использовании производных функции для определения направления движения итераций к оптимальному значению. Метод Ньютона обеспечивает быструю сходимость к оптимальному значению, но требует наличия аналитической формулы для вычисления производных функции.

Еще одной стратегией является метод золотого сечения, который используется для поиска экстремума функции на заданном отрезке. Он основан на делении отрезка на два равных отрезка и выборе нового отрезка с меньшим значением функции. Метод золотого сечения гарантирует нахождение оптимального значения функции при условии, что функция является унимодальной.

В аналитике данных также часто применяется метод случайного поиска, который основан на случайном выборе значений переменных функции и оценке их влияния на значение функции. Этот метод подходит для функций с большим количеством локальных экстремумов, но может потребовать большого количества итераций для достижения оптимального значения.

В зависимости от конкретной задачи и характеристик функции, аналитик данных может выбирать оптимальную стратегию нахождения оптимальных значений. Знание различных стратегий и их особенностей позволяет эффективно решать задачи анализа данных и оптимизации моделей.

Метод градиентного спуска

Идея метода заключается в том, чтобы найти направление наискорейшего убывания функции и двигаться в этом направлении до достижения локального минимума. В качестве направления спуска выбирается антиградиент функции, то есть вектор, направление которого противоположно градиенту функции.

Алгоритм градиентного спуска состоит из следующих шагов:

- Инициализация начальных значений переменных.

- Вычисление градиента функции в текущей точке.

- Обновление значений переменных с использованием градиента и шага обучения.

- Повторение шагов 2-3 до достижения заданного критерия остановки или сходимости.

Одним из важных параметров метода является шаг обучения, который определяет величину изменения переменных на каждой итерации. Если шаг выбран слишком малым, то алгоритм может сходиться слишком медленно. Если же шаг выбран слишком большим, то алгоритм может расходиться или пропустить оптимальное значение.

Преимущества метода градиентного спуска включают его простоту и эффективность. Однако, в некоторых случаях этот метод может застрять в локальных минимумах или седловых точках функции, что приводит к неоптимальным решениям. Для решения этой проблемы могут использоваться модификации метода, такие как стохастический градиентный спуск или методы второго порядка.

Метод Ньютона

Принцип работы метода Ньютона заключается в следующем:

- Выбирается начальное значение переменной, которое является приближением к оптимальному значению функции.

- Вычисляется значение производной функции в точке, соответствующей текущему значению переменной.

- Построение касательной к кривой в этой точке и нахождение пересечения касательной с осью абсцисс.

- Полученное пересечение становится новым значением переменной, и процесс повторяется до достижения заданной точности или оптимального значения функции.

Метод Ньютона обладает высокой скоростью сходимости, но требует изначального приближения к оптимальному значению функции. Если начальное приближение неудачно выбрано, метод может сойтись к локальному минимуму или максимуму, а не к глобальному оптимуму.

Таблица ниже иллюстрирует процесс работы метода Ньютона на примере функции f(x) = x^2 - 4x + 5:

| № итерации | Текущее значение x | Значение f(x) |

|---|---|---|

| 1 | 2 | 5 |

| 2 | 1.75 | 4.5625 |

| 3 | 1.7142857 | 4.4897959 |

| 4 | 1.7132867 | 4.4893598 |

| 5 | 1.7132865 | 4.4893598 |

Как видно из таблицы, метод Ньютона сошелся к оптимальному значению функции приближенно после нескольких итераций.

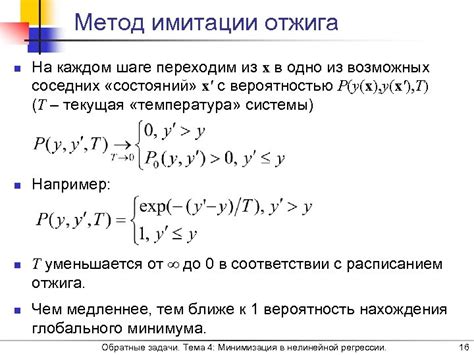

Метод алгоритма имитации отжига

Идея алгоритма заключается в имитации физического процесса отжига материала, где в начале процесса система находится в состоянии высокой энергии, и затем постепенно охлаждается, что позволяет частицам спуститься в состояние с более низкой энергией. В контексте поиска оптимальных значений функции, система соответствует состоянию переменных функции, а энергия системы - значение функции.

Алгоритм имитации отжига начинается с задания начального состояния переменных функции. Затем в цикле происходит итеративное обновление состояния переменных путем применения различных операторов, которые изменяют значения переменных функции с заданной вероятностью.

Основным элементом алгоритма является функция перехода, которая определяет вероятность принятия нового состояния переменных в зависимости от изменения значения функции. Если новое состояние оказалось лучше (т.е. значение функции уменьшилось), то оно принимается безусловно. Однако, если новое состояние оказалось хуже (т.е. значение функции увеличилось), то оно принимается с вероятностью, которая уменьшается по мере уменьшения значения функции и температуры.

Температура является главным параметром алгоритма и определяет вероятность принятия нового состояния с ухудшением функции. В начале алгоритма температура высокая, что позволяет алгоритму принимать изменения со значительным увеличением значения функции. По мере продвижения на более низкие значения функции, температура постепенно уменьшается, что приводит к более жесткому отбору новых состояний. Этот процесс аналогичен охлаждению материала при физическом отжиге.

Алгоритм имитации отжига продолжается до достижения заданного критерия остановки, например, достижение заданной точности или заданного числа итераций. В конечном итоге, алгоритм находит оптимальные значения переменных функции, соответствующие экстремуму функции.

Метод случайного поиска

Основная идея метода случайного поиска заключается в том, что случайное выбор точек в области определения функции позволяет исследовать различные регионы функции и находить локальные экстремумы. Для этого необходимо задать начальное число итераций и предельное значение ошибки.

Процесс работы метода случайного поиска следующий:

| Шаг | Описание |

| 1 | Задать начальные значения переменных |

| 2 | Сгенерировать случайные точки в области определения функции |

| 3 | Вычислить значения функции в каждой точке |

| 4 | Найти точку с наименьшим (или наибольшим) значением функции |

| 5 | Повторить шаги 2-4 заданное число итераций или пока не достигнуто предельное значение ошибки |

Метод случайного поиска имеет ряд преимуществ и недостатков. Преимущества включают простоту реализации, возможность нахождения локальных оптимумов и использование многоядерных систем для ускорения процесса. Недостатки включают затратность вычислительных ресурсов, неустойчивость к выбору начальных значений и трудности с нахождением глобальных оптимумов.

В целом, метод случайного поиска является одним из важных инструментов в аналитике данных. Он позволяет находить оптимальные значения для различных задач, таких как оптимизация параметров моделей машинного обучения, подбор оптимальных решений и многое другое.

Метод генетического алгоритма

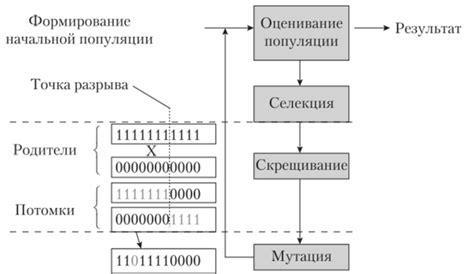

Генетический алгоритм начинает с создания случайной популяции, состоящей из особей, которые представляют собой набор параметров функции. Каждая особь имеет свое значение функции приспособленности, которое определяется, насколько хорошо она решает задачу.

Затем происходит этап отбора, в ходе которого особи с самым высоким значением функции приспособленности имеют больше шансов передать свои генетические характеристики на следующее поколение. Особи с низким значением функции приспособленности выбывают из популяции.

Для формирования нового поколения особей происходит скрещивание, которое основано на комбинировании генетического материала родителей. В результате получается новая популяция с некоторыми генетическими изменениями.

Далее происходит мутация, при которой малая часть генетического материала каждой особи меняется случайным образом. Это позволяет сохранять разнообразие в популяции и избегать преждевременной сходимости к локальному оптимуму.

Процесс отбора, скрещивания и мутации повторяется в цикле до достижения определенного условия окончания алгоритма, например, фиксированного количества поколений или достижения определенного значения функции приспособленности.

Метод генетического алгоритма является эффективным инструментом для поиска экстремума функций в аналитике данных. Он позволяет исследовать большие пространства параметров и находить оптимальные значения при минимальных затратах ресурсов.