MPI_MAX - это одна из функций MPI (Message Passing Interface), которая позволяет находить максимальное значение среди всех элементов в заданном наборе данных. Наиболее распространенным применением MPI_MAX является параллельный поиск максимального значения в массиве или других структурах данных.

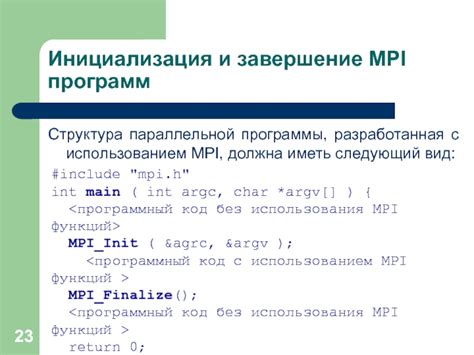

Использование MPI_MAX требует знания основных концепций и функций MPI. Прежде чем использовать MPI_MAX, необходимо разделить задачи и данные между процессами, инициализировать среду MPI и создать коммуникаторы для обмена сообщениями.

Вот пример использования MPI_MAX для нахождения максимального значения в массиве:

#include <stdio.h>

#include <mpi.h>

int main(int argc, char** argv) {

int rank, size;

int *data, *subdata; // массив данных

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

// Генерация случайных данных или ввод пользователем

subdata = (int *)malloc(sizeof(int) * size);

// Разделение данных между процессами

MPI_Scatter(data, size, MPI_INT, subdata, size, MPI_INT, 0, MPI_COMM_WORLD);

// Нахождение локального максимального значения

int local_max = subdata[0];

for (int i = 1; i < size; i++) {

if (subdata[i] > local_max) {

local_max = subdata[i];

}

}

// Нахождение глобального максимального значения

int global_max;

MPI_Reduce(&local_max, &global_max, 1, MPI_INT, MPI_MAX, 0, MPI_COMM_WORLD);

if (rank == 0) {

printf("Максимальное значение: %d

", global_max);

}

MPI_Finalize();

return 0;

}

В данном примере каждый процесс получает часть массива данных и находит локальное максимальное значение. Затем глобальное максимальное значение находится с помощью MPI_MAX с использованием функции MPI_Reduce. Наконец, процесс с рангом 0 печатает найденное максимальное значение. Пример является простым введением в использование MPI_MAX и может быть расширен и оптимизирован для больших массивов и более сложных структур данных.

Описание MPI_MAX и его возможности

Операция MPI_MAX может быть использована в сценариях, где требуется найти максимальное значение из набора данных, распределенных на различных процессах. Например, в вычислениях на кластере, MPI_MAX может быть применен для нахождения максимального элемента массива, наблюдаемого из разных процессов.

MPI_MAX выполняет сравнение элементов, отправленных каждым процессом, и возвращает максимальное значение среди них в определенную переменную результата. Эта переменная находится только на том процессе, который вызывает операцию MPI_MAX.

Для использования MPI_MAX необходимо использовать функцию MPI_Reduce(). В качестве аргумента, отвечающего за операцию сбора, следует указать MPI_MAX.

| Процесс | Общий массив |

|---|---|

| Процесс 0 | [1, 5, 3] |

| Процесс 1 | [7, 4, 2] |

| Процесс 2 | [6, 8, 9] |

В данном примере каждый процесс имеет свой локальный массив. После сбора данных при помощи MPI_Reduce() с операцией MPI_MAX, результирующий массив будет выглядеть следующим образом: [7, 8, 9].

Использование MPI_MAX позволяет эффективно и удобно находить максимальное значение, а также может быть комбинировано с другими операциями сбора по необходимости.

Как работает MPI_MAX

Для использования функции MPI_MAX необходимо подключить заголовочный файл mpi.h и указать коммуникатор, в рамках которого выполняется операция.

Пример кода:

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

int rank, size;

int data[5] = {1, 10, 5, 3, 7};

int max_value;

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

// Вызов функции MPI_MAX

MPI_Reduce(&data, &max_value, 1, MPI_INT, MPI_MAX, 0, MPI_COMM_WORLD);

if (rank == 0) {

printf("Максимальное значение: %d

", max_value);

}

MPI_Finalize();

return 0;

}

В данном примере несколько процессоров (size) рассылают массив data друг другу в рамках коммуникатора MPI_COMM_WORLD. Функция MPI_MAX находит максимальное значение из переданных массивов и записывает его в переменную max_value процессора с рангом 0.

Как видно из примера, функция MPI_MAX позволяет легко и эффективно находить максимальное значение в массиве данных, распределенном по нескольким процессорам.

Примеры кода с MPI_MAX

Вот пример кода, который иллюстрирует использование функции MPI_MAX:

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

int rank, size;

int local_value = 1;

int global_max;

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

// Каждый процесс имеет своё локальное значение

local_value = rank + 1;

// Находим максимальное значение среди всех процессов

MPI_Allreduce(&local_value, &global_max, 1, MPI_INT, MPI_MAX, MPI_COMM_WORLD);

if (rank == 0) {

printf("Максимальное значение: %d

", global_max);

}

MPI_Finalize();

return 0;

}

Этот код выполняет следующее:

- Инициализирует MPI и получает ранг и размер коммуникатора

- Каждый процесс устанавливает своё локальное значение

- Использует функцию MPI_Allreduce для нахождения максимального значения среди всех процессов

- Завершает работу MPI

Данный пример демонстрирует, как использовать функцию MPI_MAX для нахождения максимального значения среди всех процессов. Он особенно полезен в задачах, требующих параллельного поиска максимального значения в больших данных.

Пример использования MPI_MAX в решении задачи поиска максимального значения

Рассмотрим пример использования MPI_MAX в задаче поиска максимального значения в массиве чисел.

#include <stdio.h>

#include <mpi.h>

int main(int argc, char *argv[]) {

int rank, size;

int numbers[] = {2, 5, 10, 3, 7};

int max_number = 0;

MPI_Init(&argc,&argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Comm_size(MPI_COMM_WORLD, &size);

// Вычисление локального максимального значения

int local_max = 0;

for (int i = rank; i < 5; i += size) {

if (numbers[i] > local_max) {

local_max = numbers[i];

}

}

// Поиск глобального максимального значения

MPI_Reduce(&local_max, &max_number, 1, MPI_INT, MPI_MAX, 0, MPI_COMM_WORLD);

if (rank == 0) {

printf("Максимальное значение: %d

", max_number);

}

MPI_Finalize();

return 0;

} Таким образом, с использованием MPI_MAX можно эффективно решить задачу поиска максимального значения в массиве чисел или в других подобных случаях.

Пример использования MPI_MAX в параллельной сортировке

Ниже приведен пример кода, демонстрирующий использование MPI_MAX в параллельной сортировке:

- Импортировать необходимые библиотеки:

#include#include #include

- Определить функцию сравнения для сортировки:

int compare(const void *a, const void *b) {

return (*(int*)a - *(int*)b);

}

- Инициализировать MPI:

MPI_Init(NULL, NULL);

- Получить число процессов и ранг текущего процесса:

int size, rank; MPI_Comm_size(MPI_COMM_WORLD, &size); MPI_Comm_rank(MPI_COMM_WORLD, &rank);

- Создать массив данных для сортировки:

int data[size];

- Заполнить массив данных случайными значениями:

srandom(rank);

for (int i = 0; i < size; i++) {

data[i] = random();

}

- Отсортировать массив данных с использованием функции сравнения:

qsort(data, size, sizeof(int), compare);

- Найти максимальное значение среди результатов каждого процесса:

int max; MPI_Reduce(&data[size - 1], &max, 1, MPI_INT, MPI_MAX, 0, MPI_COMM_WORLD);

- Вывести результат на экран:

if (rank == 0) {

printf("Максимальное значение: %d

", max);

}

- Завершить MPI:

MPI_Finalize();

В данном примере каждый процесс сортирует свою часть данных, а затем использует MPI_MAX для нахождения максимального значения среди результатов всех процессов. Это позволяет эффективно распараллеливать сортировку и находить максимальное значение на нескольких процессах.

Практическое руководство по использованию MPI_MAX

Вот пример использования MPI_MAX:

- Инициализируйте MPI командой

MPI_Init(). - Создайте коммуникатор с использованием команды

MPI_Comm_rank()для определения номера текущего процесса. - Инициализируйте массив значений, для которого нужно найти максимальное значение.

- Вызовите функцию

MPI_Allreduce()с операциейMPI_MAXдля поиска максимального значения в массиве. - Получите результат с использованием функции

MPI_Reduce(). - Завершите MPI командой

MPI_Finalize().

Пример кода:

#include <stdio.h>

#include <mpi.h>

int main(int argc, char *argv[]) {

int rank, size;

int values[] = {3, 1, 2, 5, 4};

int max_value;

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

MPI_Allreduce(&values, &max_value, 1, MPI_INT, MPI_MAX, MPI_COMM_WORLD);

if (rank == 0) {

printf("Максимальное значение: %d

", max_value);

}

MPI_Finalize();

return 0;

}Важно отметить, что операция MPI_MAX предоставляет возможность вычисления максимального значения только для одного типа данных. Если вам нужно найти максимальное значение из нескольких различных типов данных, вам придется использовать операцию MPI_MAXLOC.

Использование MPI_MAX позволяет эффективно распараллеливать вычисления и ускорять процесс поиска максимального значения в параллельных системах.

Шаги для использования MPI_MAX

Использование функции MPI_MAX в параллельных вычислениях, осуществляемых с помощью библиотеки MPI, происходит в несколько шагов:

1. Инициализация MPI.

Перед использованием функции MPI_MAX необходимо инициализировать библиотеку MPI с помощью вызова функции MPI_Init. Этот шаг обеспечивает правильную инициализацию параллельной среды.

2. Создание коммуникатора.

Для использования функции MPI_MAX необходимо создать коммуникатор с помощью вызова функции MPI_Comm_create. Коммуникатор является средством связи между процессами и определяет группу процессов, среди которых будет происходить синхронизация и обмен данными.

3. Распределение данных.

Перед вызовом функции MPI_MAX необходимо распределить данные между процессами. Для этого можно использовать функции MPI_Scatter или MPI_Bcast в зависимости от требуемой логики вычислений.

4. Вызов MPI_MAX.

Вызов функции MPI_MAX осуществляется путем передачи указателя на массив данных, указателя на переменную-результат и количество элементов массива каждому процессу коммуникатора. Функция MPI_MAX выполняет поэлементное сравнение данных и возвращает максимальное значение среди всех процессов.

5. Синхронизация результатов.

После вызова функции MPI_MAX каждый процесс содержит максимальное значение элемента. Для получения конечного результата необходимо выполнить операцию синхронизации между процессами коммуникатора с помощью функции MPI_Barrier.

6. Отправка результатов.

После синхронизации результатов необходимо передать значение переменной-результата от каждого процесса коммуникатора в основной процесс. Для этого можно использовать функцию MPI_Gather или MPI_Reduce в зависимости от необходимости.

7. Завершение программы.

После завершения работы с функцией MPI_MAX необходимо освободить ресурсы, занятые библиотекой MPI, с помощью вызова функции MPI_Finalize. Этот шаг обеспечивает корректное завершение параллельной среды.

Рекомендации по оптимизации работы с MPI_MAX

Использование функции MPI_MAX позволяет находить максимальное значение из всех элементов, распределенных по процессорам в параллельных вычислениях с использованием MPI. Однако, чтобы достичь максимальной эффективности, стоит учесть несколько рекомендаций:

- Избегайте ненужной коммуникации. Вместо того чтобы использовать MPI_MAX на каждом процессоре, который затем будет коммуницировать с остальными процессорами для нахождения общего максимального значения, вы можете использовать функцию MPI_ALLREDUCE с операцией MPI_MAX. Это позволяет найти максимальное значение во всех процессах и автоматически распределить его на все процессоры.

- Уменьшайте время ожидания коммуникации. Если ваша программа делает множество вызовов функции MPI_MAX, стоит объединить все эти вызовы в один блок коммуникации. Это позволяет сэкономить время на ожидании передачи сообщений между процессорами. Кроме того, использование неблокирующей коммуникации (MPI_IALLREDUCE) может значительно сократить время ожидания и улучшить общую производительность.

- Используйте правильные типы данных. В зависимости от вашей конкретной задачи, может потребоваться использовать различные типы данных для функции MPI_MAX. Обратитесь к руководству по MPI для определения правильного типа данных в вашем случае.

- Оптимизируйте распределение данных. Если вам требуется найти максимальное значение только для определенного подмножества процессоров, то имеет смысл распределять данные только между этими процессорами. Это поможет уменьшить объем коммуникации и повысить производительность системы.

- Используйте сбалансированную нагрузку. Убедитесь, что ваша программа использует все доступные процессоры равномерно. Неравномерная нагрузка может привести к низкой производительности и неэффективному использованию ресурсов.

- Проверьте производительность программы на различных размерах данных и различном количестве процессоров. Это поможет выявить узкие места, оптимизировать программу и выбрать наилучшую конфигурацию для вашей задачи.

- Используйте современные техники оптимизации. Существует множество методов и инструментов для оптимизации параллельных программ. Изучите эти методы и применяйте их для оптимизации работу с MPI_MAX.

Следуя этим рекомендациям, вы сможете оптимизировать работу с функцией MPI_MAX и достичь максимальной производительности вашей параллельной программы.